MemVerge, un proveedor de software diseñado para acelerar y optimizar aplicaciones con uso intensivo de datos, se ha asociado con Micron para impulsar el rendimiento de los LLM utilizando la tecnología Compute Express Link (CXL).

El software Memory Machine de la empresa utiliza CXL para reducir el tiempo de inactividad en las GPU provocado por la carga de memoria.

La tecnología se demostró en el stand de Micron en NVIDIA GTC 2024 y Charles Fan, director ejecutivo y cofundador de MemVerge, dijeron: “Ampliar el rendimiento de LLM de manera rentable significa mantener las GPU alimentadas con datos. Nuestra demostración en GTC demuestra que los grupos de memoria por niveles no solo aumentan el rendimiento sino que también maximizan la utilización de valiosos recursos de GPU”.

Resultados impresionantes

La demostración utilizó un motor de generación FlexGen de alto rendimiento y un modelo de lenguaje grande OPT-66B. Esto se realizó en un servidor Supermicro Petascale, equipado con un AMD CPU Genoa, GPU Nvidia A10, DIMM Micron DDR5-4800, módulos de memoria CZ120 CXL y software de organización por niveles inteligente MemVerge Memory Machine X.

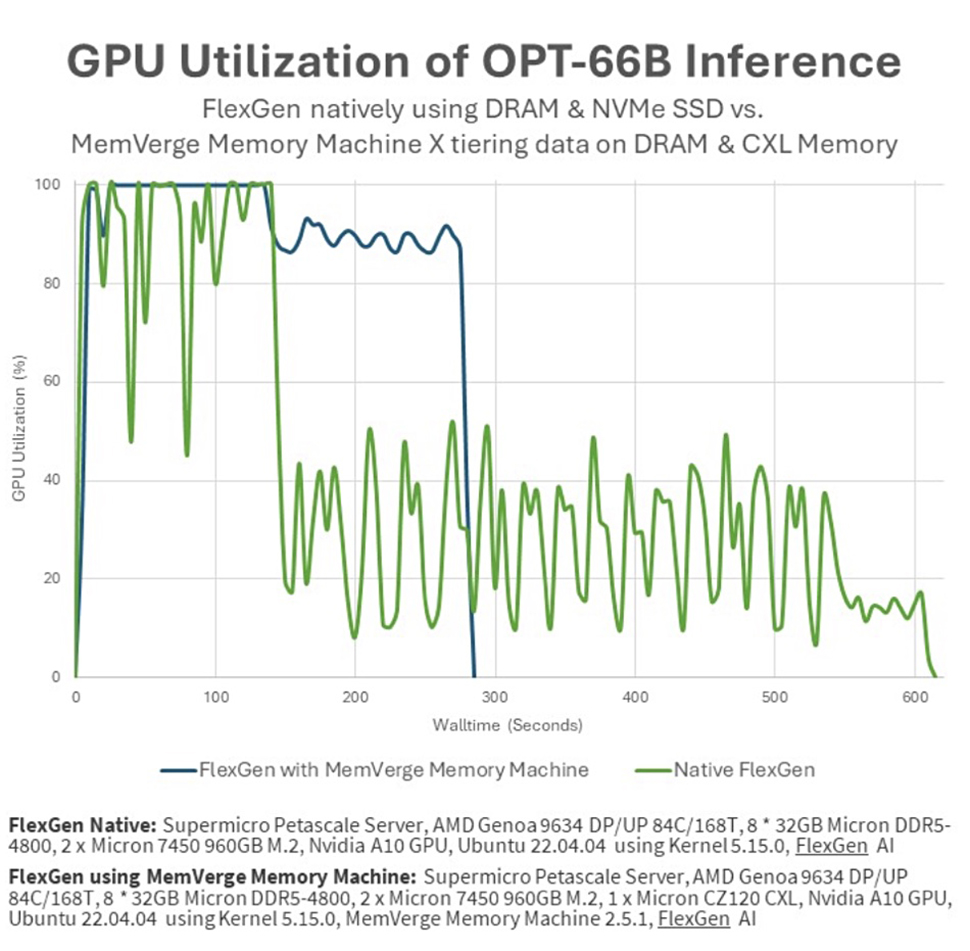

La demostración comparó el rendimiento de un trabajo que se ejecuta en una GPU A10 con 24 GB de memoria GDDR6 y datos alimentados desde 8x 32 GB Micron DRAM, con el mismo trabajo que se ejecuta en el servidor Supermicro equipado con el expansor de memoria Micron CZ120 CXL de 24 GB y el software MemVerge.

El punto de referencia FlexGen, que utiliza memoria por niveles, completó tareas en menos de la mitad del tiempo que los métodos de almacenamiento NVMe tradicionales. Además, la utilización de GPU aumentó del 51,8% al 91,8%, supuestamente como resultado de la clasificación de datos transparente del software MemVerge Memory Machine X en GPU, CPU y memoria CXL.

Raj Narasimhan, vicepresidente senior y gerente general de la Unidad de Negocios de Computación y Redes de Micron, dijo: «A través de nuestra colaboración con MemVerge, Micron puede demostrar los beneficios sustanciales de los módulos de memoria CXL para mejorar el rendimiento efectivo de la GPU para aplicaciones de IA, lo que resulta en un tiempo de ejecución más rápido». insights para los clientes. Las innovaciones de Micron en toda la cartera de memorias brindan computación con la capacidad de memoria y el ancho de banda necesarios para escalar los casos de uso de IA desde la nube hasta el borde”.

Sin embargo, los expertos se muestran escépticos ante estas afirmaciones. Bloques y archivos Señaló que la GPU Nvidia A10 utiliza memoria GDDR6, que no es HBM. Un portavoz de MemVerge respondió a este punto, y a otros que planteó el sitio, afirmando: “Nuestra solución tiene el mismo efecto en las otras GPU con HBM. Entre las capacidades de descarga de memoria de Flexgen y las capacidades de almacenamiento en niveles de Memory Machine X, la solución gestiona toda la jerarquía de memoria que incluye módulos de memoria GPU, CPU y CXL”.