El Instituto Nacional de Estándares y Tecnología (NIST) de EE. UU. llama la atención sobre la desafíos de privacidad y seguridad que surgen como resultado del mayor despliegue de sistemas de inteligencia artificial (IA) en los últimos años.

«Estos desafíos de seguridad y privacidad incluyen el potencial de manipulación adversa de los datos de entrenamiento, explotación adversaria de las vulnerabilidades del modelo para afectar negativamente el rendimiento del sistema de IA, e incluso manipulaciones maliciosas, modificaciones o mera interacción con modelos para filtrar información sensible sobre las personas representadas en los datos, sobre el modelo en sí o datos empresariales patentados», NIST dicho.

A medida que los sistemas de IA se integran rápidamente en los servicios en línea, en parte impulsado por la aparición de sistemas de IA generativos como OpenAI ChatGPT y Google Bard, los modelos que impulsan estas tecnologías enfrentan una serie de amenazas en diversas etapas de las operaciones de aprendizaje automático.

Estos incluyen datos de capacitación corruptos, fallas de seguridad en los componentes del software, envenenamiento del modelo de datos, debilidades de la cadena de suministro y violaciones de la privacidad que surgen como resultado de ataques de inyección rápida.

«En su mayor parte, los desarrolladores de software necesitan que más personas utilicen su producto para que pueda mejorar con la exposición», dijo el científico informático del NIST, Apostol Vassilev. «Pero no hay garantía de que la exposición sea buena. Un chatbot puede arrojar información mala o tóxica cuando se le solicita con un lenguaje cuidadosamente diseñado».

Los ataques, que pueden tener impactos significativos en la disponibilidad, la integridad y la privacidad, se clasifican en términos generales de la siguiente manera:

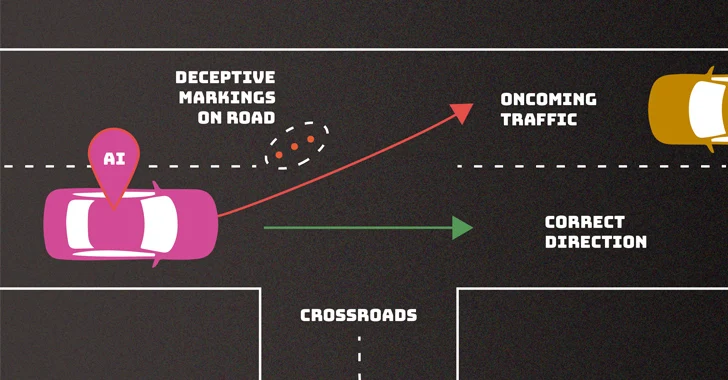

- Ataques de evasión, que tienen como objetivo generar resultados adversarios después de implementar un modelo.

- Ataques de envenenamiento, que apuntan a la fase de entrenamiento del algoritmo mediante la introducción de datos corruptos.

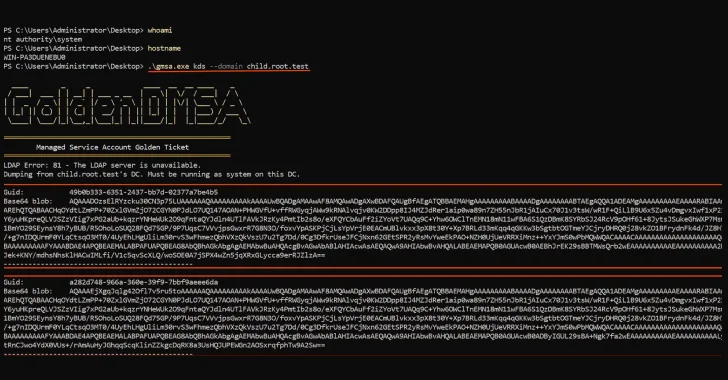

- Ataques a la privacidad, que tienen como objetivo obtener información confidencial sobre el sistema o los datos con los que fue entrenado planteando preguntas que eluden las barreras de seguridad existentes.

- Ataques de abuso, cuyo objetivo es comprometer fuentes legítimas de información, como una página web con información incorrecta, para reutilizar el uso previsto del sistema.

Dichos ataques, dijo el NIST, pueden ser llevados a cabo por actores de amenazas con pleno conocimiento (caja blanca), conocimiento mínimo (caja negra) o con una comprensión parcial de algunos de los aspectos del sistema de IA (caja gris).

La agencia señaló además la falta de medidas de mitigación sólidas para contrarrestar estos riesgos, e instó a la comunidad tecnológica en general a «idear mejores defensas».

El desarrollo llega más de un mes después de que el Reino Unido, Estados Unidos y socios internacionales de otros 16 países publicaran directrices para el desarrollo de sistemas seguros de inteligencia artificial (IA).

«A pesar de los importantes avances que han logrado la IA y el aprendizaje automático, estas tecnologías son vulnerables a ataques que pueden provocar fallos espectaculares con consecuencias nefastas», afirmó Vassilev. «Hay problemas teóricos con la seguridad de los algoritmos de IA que simplemente no se han resuelto todavía. Si alguien dice lo contrario, está vendiendo aceite de serpiente».