- Un nuevo enfoque llamado Dualpipe parece ser la clave para el éxito de Deekseek

- Un experto lo describe como una DPU virtual en la GPU que maximiza la eficiencia del ancho de banda

- Si bien Deepseek ha usado solo las GPU de Nvidia, uno se pregunta cómo le iría al instinto de AMD

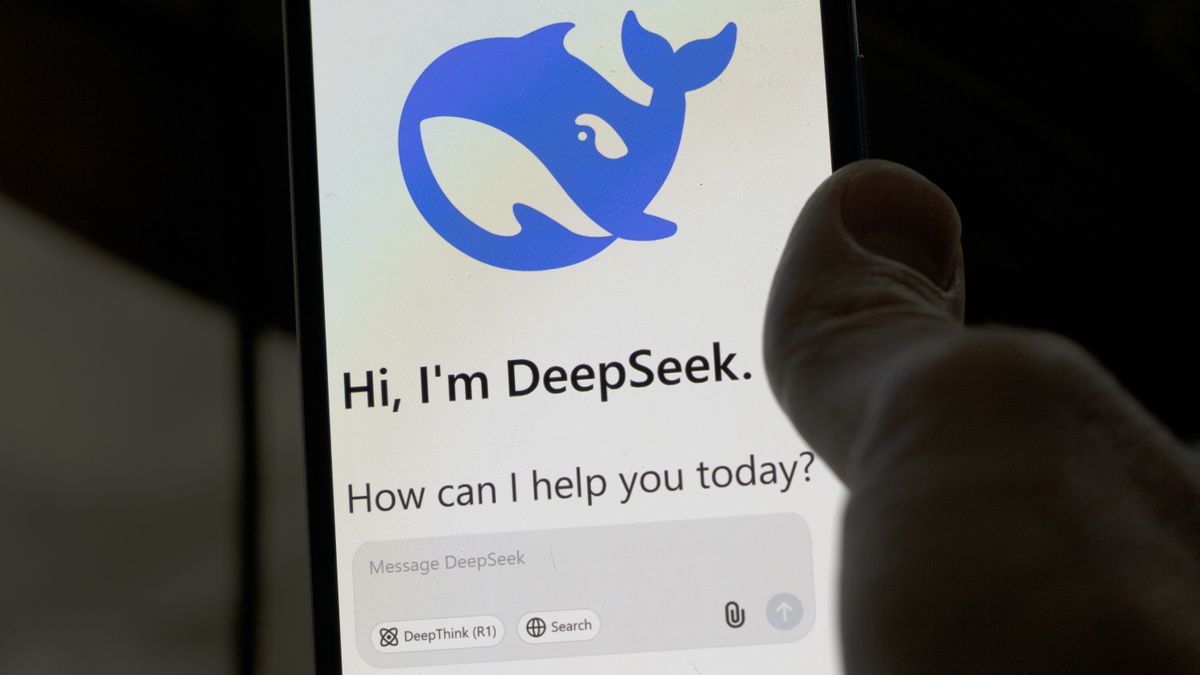

Deepseek AI de China chatbot ha sorprendido a la industria tecnológica, representando una alternativa creíble a Opadai‘s Chatgpt a una fracción del costo.

A papel reciente revelado Deepseek v3 fue entrenado en un grupo de 2,048 Nvidia H800 GPU: versiones paralizadas del H100 (solo podemos imaginar cuánto más poderoso se ejecutaría en Amd ¡Aceleradores de instinto!). Según se informa, requirió 2,79 millones de horas de GPU para el previación, ajustado, ajustado en 14.8 billones de tokens y costo, según los cálculos realizados por La siguiente plataforma – solo $ 5.58 millones.

Pero exactamente cómo los desarrolladores de Deepseek lograron esta hazaña probablemente se deba a un truco inteligente.

Una DPU virtual en la GPU en sí misma

Primero, algunos antecedentes. Deepseek es un modelo de lenguaje avanzado de la mezcla de expertos (MOE) diseñado para optimizar el rendimiento activando selectivamente solo las partes más relevantes de su arquitectura para cada tarea. La tercera versión del modelo, Deepseek-V3, presenta un total de 671 mil millones de parámetros, con solo 37 mil millones activados para cualquier predicción de token dada. Esta activación selectiva reduce masivamente los costos computacionales mientras mantiene un alto rendimiento y precisión, lo que verá si lo intenta.

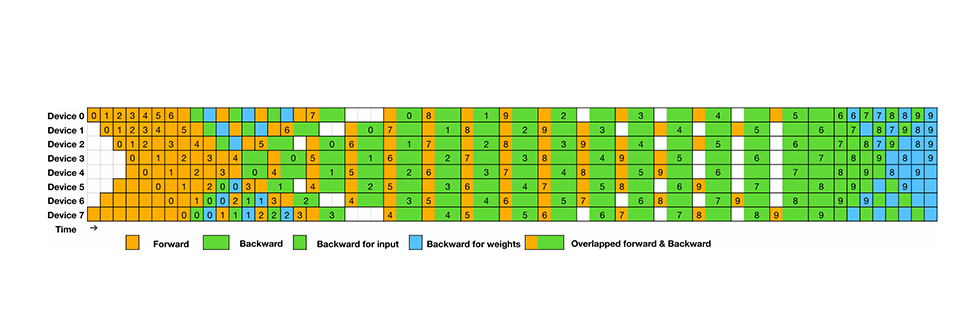

Es fácil ser escéptico de Deepseek y las afirmaciones hechas con respecto a su entrenamiento, pero el documento revela parte de la magia que los desarrolladores se les ocurrió para aprovechar al máximo el hardware paralizado con el que tuvieron que trabajar. Esto incluye la creación del algoritmo Dualpipe para el paralelismo eficiente de la tubería.

Según la información publicada por Deepseek, Dualpipe se superpone al cálculo hacia adelante y hacia atrás, reduce la latencia y optimiza el movimiento de datos a través de las GPU. Al gestionar eficientemente la comunicación, minimiza el tiempo de inactividad (burbujas de tubería) y equilibra dinámicamente los núcleos de cómputo de GPU (transmisión de multiprocesadores) entre el cálculo y la comunicación, evitando los cuellos de botella de transferencia de datos a medida que el modelo escala.

Un comentarista en La siguiente plataforma Describe Dualpipe como «esencialmente creando una DPU virtual en la GPU en sí para manejar la comunicación total», lo que destaca su papel en la optimización de la eficiencia de transferencia de datos.

El documento entra en más detalle, «Para garantizar un rendimiento computacional suficiente para Dualpipe, personalizamos los núcleos de comunicación combinados de nodos cruzados eficientes (incluido el envío y la combinación) para conservar el número de SMS dedicados a la comunicación. La implementación de Los kernels están codiseñados con el algoritmo de activación del MOE y la topología de la red de nuestro clúster.