Un gran tema actual en el ámbito de los semiconductores es el reconocimiento de que la verdadera oportunidad de mercado para el silicio de IA será el mercado de la inferencia de IA. pensamos esto tiene sentidopero empezamos a preguntarnos si alguien va a ganar dinero con esto.

El mercado de la inferencia de IA es importante por dos razones. Primero, Nvidia parece tener un bloqueo en el entrenamiento de IA. Verdadero, AMD e Intel tienen ofertas en este espacio, pero clasificémoslas como «aspiracionales» por ahora. Por el momento, este es el mercado de Nvidia. En segundo lugar, es probable que el mercado de la inferencia de IA sea mucho mayor que el mercado de la formación. El director ejecutivo de Intel, Pat Gelsinger, tiene una buena analogía para esto: los modelos meteorológicos. Sólo unas pocas entidades necesitan crear modelos de predicción del tiempo (NASA, NOAA, etc.), pero todo el mundo quiere comprobar el tiempo.

Nota del editor:

Autor invitado Jonathan Goldberg es el fundador de D2D Advisory, una firma de consultoría multifuncional. Jonathan ha desarrollado estrategias de crecimiento y alianzas para empresas de las industrias de telefonía móvil, redes, juegos y software.

Lo mismo ocurre con la IA: la utilidad de los modelos se derivará de la capacidad de los usuarios finales para utilizarlos. Como resultado, la importancia del mercado de inferencia ha sido un tema constante en todos los eventos de analistas e inversores a los que hemos asistido recientemente, e incluso Nvidia ha cambiado su posicionamiento últimamente para hablar mucho más sobre la inferencia.

Por supuesto, hay dos partes del mercado de inferencia: la nube y el borde. La inferencia en la nube se lleva a cabo en el centro de datos y la inferencia en el borde se lleva a cabo en el dispositivo. Recientemente hemos escuchado a gente debatir la definición de estos dos, los límites pueden volverse un poco borrosos. Pero creemos que el desglose es bastante sencillo: si la empresa que opera el modelo paga el gasto de capital, eso es inferencia en la nube, si el usuario final paga el gasto de capital (comprando un teléfono o una PC), eso es inferencia de borde.

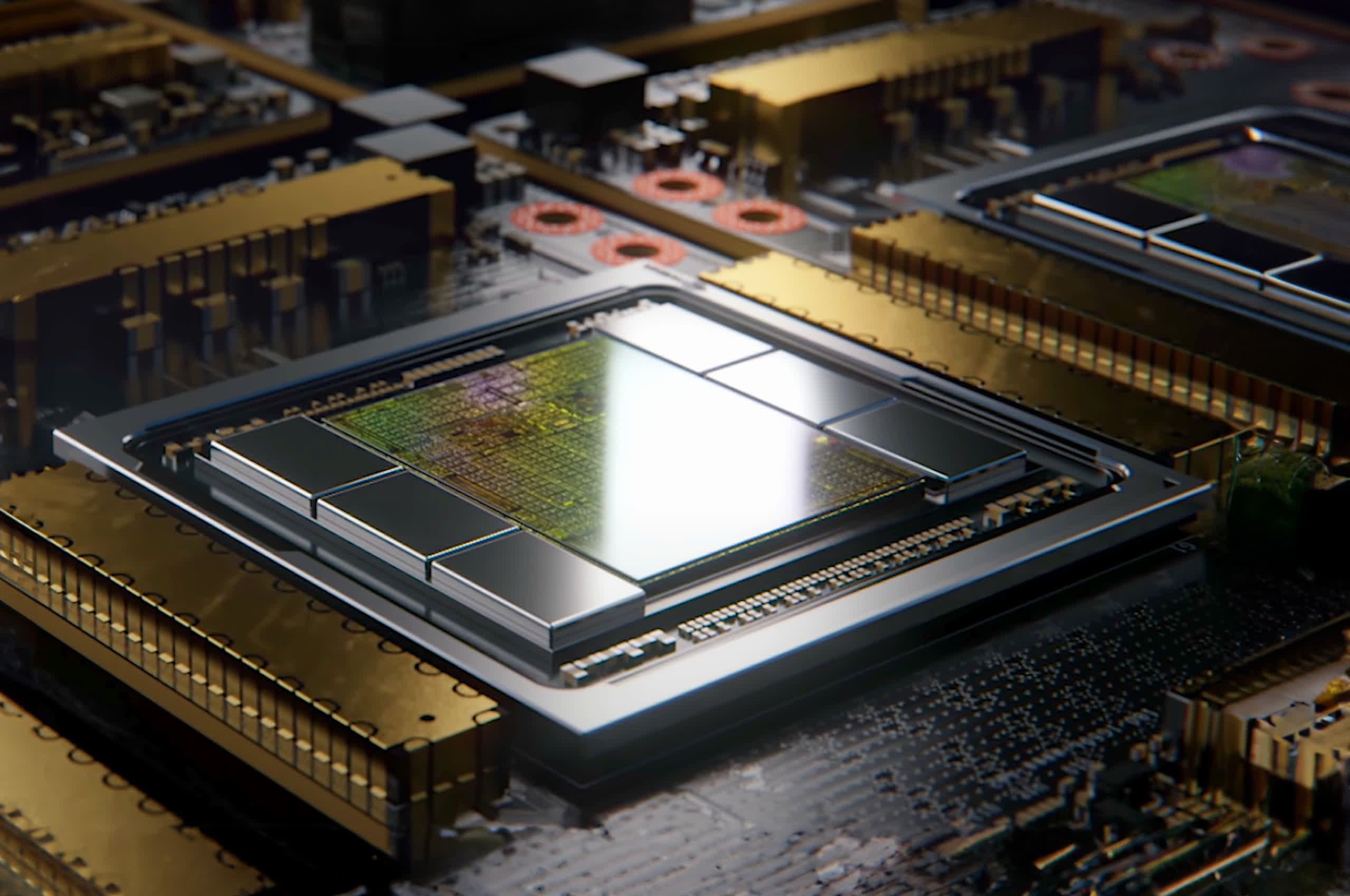

Es probable que la inferencia en la nube sea el concurso más interesante de observar. Nvidia ha articulado un caso muy fuerte por qué transferirán su dominio en el entrenamiento a la inferencia. En pocas palabras, hay mucha superposición y Nvidia tiene Cuda y otras herramientas de software para facilitar la conexión entre los dos. Sospechamos que esto atraerá a muchos clientes, estamos en una era en la que «no te despiden por comprar Nvidia» y la empresa tiene mucho que ofrecer al respecto.

Por otro lado, su grande competidores van a esforzarse mucho para conseguir su cuota de mercado. Además, los hiperescaladores que probablemente consumirán la mayor parte del silicio de inferencia tienen la capacidad de romper la dependencia de Nvidia, ya sea diseñando su propio silicio o aprovechando al máximo la competencia. Esperamos que este sea el centro de mucha atención en los próximos años.

El mercado de la inferencia de bordes es una cuestión mucho más abierta. Para empezar, nadie sabe realmente en qué medida los modelos de IA dependerán del borde. A las empresas que operan estos modelos (especialmente las hiperescaladoras) realmente les gustaría que predomine la inferencia de borde. Esto reducirá en gran medida la cantidad de dinero que tienen que gastar en la construcción de todos esos centros de datos de inferencia en la nube. Sospechamos que la economía de la IA puede no funcionar si esto no es posible.

La realidad es que no sabemos cuánto estarían dispuestos a pagar los consumidores porque no sabemos realmente qué hará la IA por los consumidores.

Dicho esto, esta visión conlleva una importante advertencia: ¿estarán realmente dispuestos los consumidores a pagar por la IA? Hoy en día, si preguntáramos al consumidor promedio cuánto pagaría por ejecutar ChatGPT en su propia computadora, sospechamos que la respuesta sería $0. Sí, están dispuestos a pagar $20 al mes para usar ChatGPT, pero ¿estarían dispuestos a pagar más para que funcione localmente? El beneficio de esto no está del todo claro, tal vez podrían obtener respuestas más rápidamente, pero ChatGPT ya es bastante rápido cuando se entrega desde la nube. Y si los consumidores no están dispuestos a pagar más por PC o teléfonos con «capacidades de IA», los fabricantes de chips no podrán cobrar primas por el silicio con esas capacidades. Mencionamos que Qualcomm enfrenta este problema en los teléfonos inteligentes, pero lo mismo se aplica a Intel y AMD para PC.

Hemos preguntado a todos sobre esto y aún no hemos obtenido una respuesta clara. La realidad es que no sabemos cuánto estarían dispuestos a pagar los consumidores porque no sabemos realmente qué hará la IA por los consumidores. Cuando se les presiona, todos los ejecutivos de semifinales con los que hablamos tienden a utilizar por defecto alguna versión de «Hemos visto algunas demostraciones increíbles, próximamente» o «Creemos que Microsoft está trabajando en algunas cosas increíbles». Estas son respuestas justas, no somos (todavía) escépticos totales de la IA e imaginamos que hay algunos proyectos increíbles en proceso.

Esta dependencia del software plantea la pregunta de cuánto valor tiene la IA para los fabricantes de semifinales. Si el valor de esos PC con IA depende de las empresas de software (especialmente microsoft) entonces es probable que se asuma que Microsoft captará la mayor parte del valor de los servicios de IA para el consumidor. Microsoft es una especie de experto en esto. Existe una posibilidad muy real de que el único impulso que provenga de las semifinales de IA sea que generen una actualización única del dispositivo. Eso será bueno durante uno o dos años, pero es mucho menor que la enorme oportunidad que algunas empresas están presentando a la IA.