A pesar de años de evidencia de lo contrario, muchos republicanos todavía creen que la victoria del presidente Joe Biden en 2020 fue ilegítima. Varios candidatos que negaron las elecciones ganaron sus primarias durante el Súper Martes, entre ellos Brandon Gillyerno del experto de derecha Dinesh D’Souza y promotor del desacreditado 2000 mulas película. De cara a las elecciones de este año, las acusaciones de fraude electoral siguen siendo un elemento básico para los candidatos que se postulan por la derecha, alimentadas por desinformación y desinformación, tanto en línea como fuera de ella.

Y la llegada de la IA generativa tiene el potencial de empeorar el problema. A nuevo reporte del Centro para Contrarrestar el Odio Digital (CCDH), una organización sin fines de lucro que rastrea el discurso de odio en las plataformas sociales, descubrió que aunque las empresas de inteligencia artificial generativa dicen que han implementado políticas para evitar que sus herramientas de creación de imágenes se utilicen para difundir elecciones. desinformación relacionada, los investigadores pudieron eludir sus salvaguardas y crear las imágenes de todos modos.

Si bien algunas de las imágenes mostraban a figuras políticas, como el presidente Joe Biden y Donald Trump, otras eran más genéricas y, según teme Callum Hood, investigador principal del CCDH, podrían ser más engañosas. Algunas imágenes creadas siguiendo las indicaciones de los investigadores, por ejemplo, mostraban milicias fuera de un lugar de votación, papeletas tiradas a la basura o máquinas de votación manipuladas. En un caso, los investigadores pudieron hacer que Dream Studio de StabilityAI generara una imagen del presidente Biden en una cama de hospital, luciendo enfermo.

«La verdadera debilidad estaba en las imágenes que podrían usarse para intentar evidenciar afirmaciones falsas de una elección robada», dice Hood. «La mayoría de las plataformas no tienen políticas claras al respecto y tampoco tienen medidas de seguridad claras».

Los investigadores del CCDH probaron 160 mensajes en ChatGPT Plus, Midjourney, Dream Studio e Image Creator, y descubrieron que Midjourney tenía más probabilidades de producir imágenes engañosas relacionadas con las elecciones, aproximadamente el 65 por ciento de las veces. Los investigadores solo pudieron solicitar a ChatGPT Plus que lo hiciera el 28 por ciento de las veces.

«Esto demuestra que puede haber diferencias significativas entre las medidas de seguridad que implementan estas herramientas», dice Hood. «Si uno sella estas debilidades de manera tan efectiva, significa que los demás realmente no se han molestado».

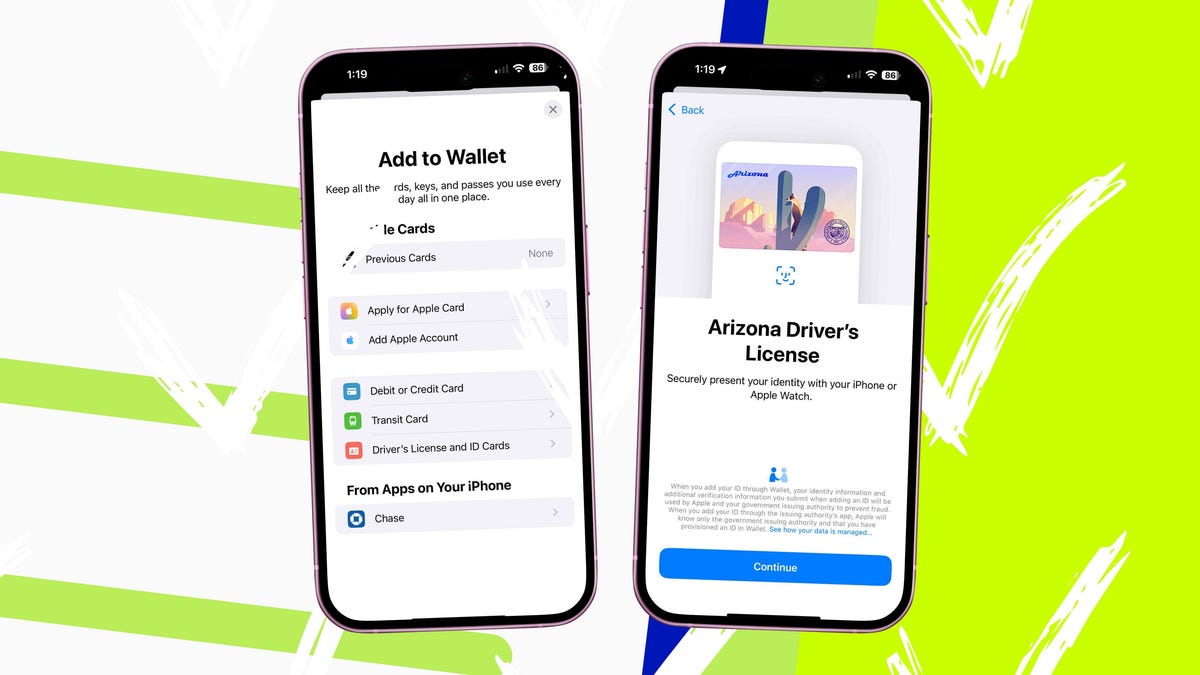

En enero, OpenAI Anunciado estaba tomando medidas para “asegurarse de que nuestra tecnología no se utilice de una manera que pudiera socavar este proceso”, incluida la prohibición de imágenes que disuadieran a las personas de “participar en procesos democráticos”. En febrero, Bloomberg informó que Midjourney estaba considerando prohibir la creación de imágenes políticas en su conjunto. Dream Studio prohíbe generar contenido engañoso, pero no parece tener una política electoral específica. Y aunque Image Creator prohíbe la creación de contenido que pueda amenazar la integridad electoral, aún permite a los usuarios generar imágenes de figuras públicas.

Kayla Wood, portavoz de OpenAI, dijo a WIRED que la compañía está trabajando para “mejorar la transparencia en el contenido generado por IA y diseñar mitigaciones como rechazar solicitudes que soliciten la generación de imágenes de personas reales, incluidos los candidatos. Estamos desarrollando activamente herramientas de procedencia, incluida la implementación de credenciales digitales C2PA, para ayudar a verificar el origen de las imágenes creadas por DALL-E 3. Continuaremos adaptándonos y aprendiendo del uso de nuestras herramientas”.

Microsoft, OpenAI, StabilityAI y Midjourney no respondieron a las solicitudes de comentarios.

A Hood le preocupa que el problema con la IA generativa sea doble: las plataformas de IA generativa no sólo deben evitar la creación de imágenes engañosas, sino que las plataformas deben poder detectarlas y eliminarlas. A informe reciente de IEEE Spectrum descubrió que el propio sistema de Meta para marcar el contenido generado por IA con marcas de agua se podía eludir fácilmente.

“Por el momento las plataformas no están especialmente preparadas para esto. Por lo tanto, las elecciones serán una de las verdaderas pruebas de seguridad en torno a las imágenes de IA”, afirma Hood. «Necesitamos tanto las herramientas como las plataformas para avanzar mucho más en esto, particularmente en torno a imágenes que podrían usarse para promover acusaciones de elecciones robadas o disuadir a la gente de votar».