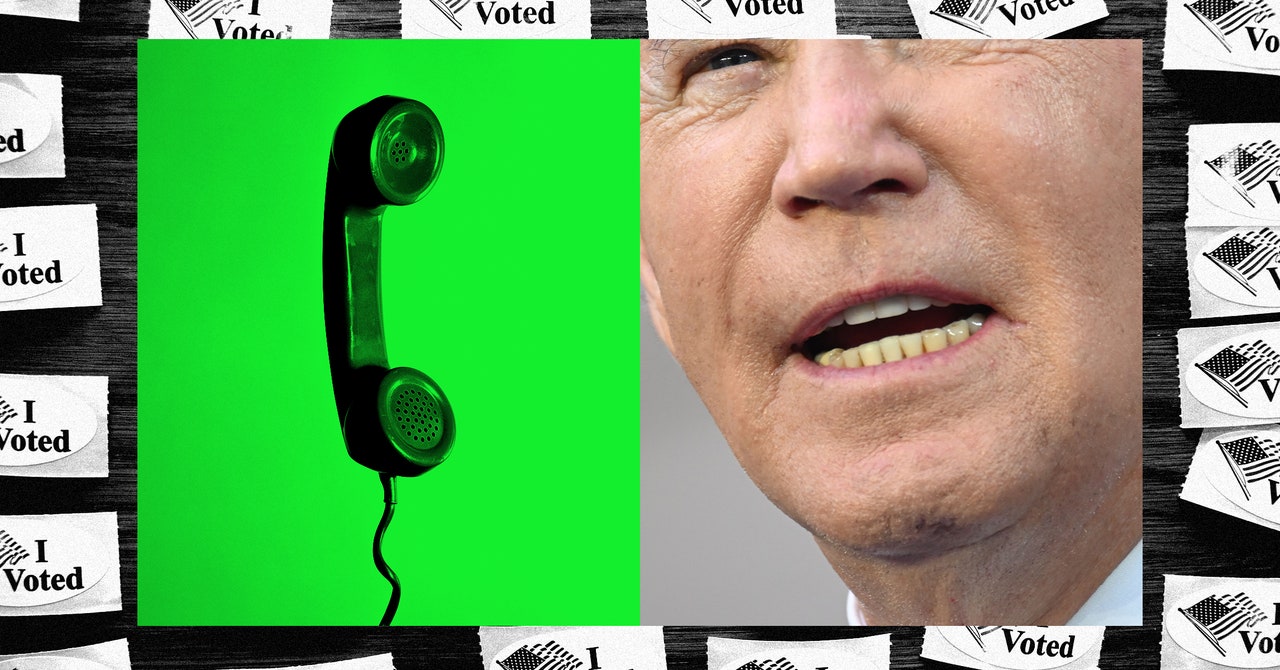

“En la política estadounidense, lamentablemente la desinformación se ha convertido en algo común. Pero ahora, la desinformación, junto con las nuevas herramientas generativas de inteligencia artificial, están creando una amenaza sin precedentes para la que no estamos preparados”, dijo Clarke en un comunicado a WIRED el lunes. “Éste es un problema que tanto demócratas como republicanos deberían poder abordar juntos. El Congreso necesita manejar esto antes de que las cosas se salgan de control”.

Grupos de defensa como Public Citizen han solicitado a la Comisión Federal Electoral que emita nuevas reglas que exijan la divulgación de anuncios políticos similares a las que han propuesto Clarke y Klobuchar, pero aún no han tomado ninguna decisión formal. A principios de este mes, el presidente de la FEC, Sean Cooksey, un republicano, dijo El Correo de Washington que la comisión planea tomar una decisión a principios del verano. Para entonces, El Partido Republicano probablemente ya habrá elegido a Trump como su candidato.y las elecciones generales estarán en marcha.

«Ya seas demócrata o republicano, nadie quiere ver anuncios falsos o llamadas automáticas en las que ni siquiera puedes saber si es tu candidato o no», dijo Klobuchar a WIRED el lunes. «Necesitamos medidas federales para garantizar que esta poderosa tecnología no se utilice para engañar a los votantes y difundir desinformación».

Las falsificaciones de audio son especialmente perniciosas porque, a diferencia de las fotos o vídeos falsificados, carecen de muchas de las señales visuales que podrían ayudar a alguien a identificar que han sido alterados, dice Hany Farid, profesor de la Escuela de Información de UC Berkeley. «Con las llamadas automáticas, la calidad del audio en un teléfono no es excelente, por lo que es más fácil engañar a las personas con audio falso».

A Farid también le preocupa que las llamadas telefónicas, a diferencia de las publicaciones falsas en las redes sociales, tengan más probabilidades de llegar a un grupo demográfico de mayor edad que ya susceptible a estafas.

«Se podría argumentar que muchas personas descubrieron que este audio era falso, pero el problema en una primaria estatal es que incluso unos pocos miles de votos podrían tener un impacto en los resultados», dice. «Por supuesto, este tipo de interferencia electoral podría llevarse a cabo sin deepfakes, pero la preocupación es que los deepfakes impulsados por IA hacen que estas campañas sean más efectivas y más fáciles de llevar a cabo».

La regulación concreta se ha quedado atrás en gran medida, incluso cuando los deepfakes como el utilizado por la llamada automática se vuelven más baratos y más fáciles de producir, dice Sam Gregory, director de programa de Witness, una organización sin fines de lucro que ayuda a las personas a utilizar la tecnología para promover los derechos humanos. «Ya no parece un robot», dice.

«La gente en esta área realmente ha luchado con la forma de marcar el audio para mostrar que su procedencia es sintética», dice. “Por ejemplo, puedes obligar a las personas a poner un descargo de responsabilidad al comienzo de un fragmento de audio que diga que fue creado con IA. Si eres un mal actor o alguien que realiza una llamada automática engañosa, obviamente no lo haces”.

Incluso si un fragmento de contenido de audio tiene una marca de agua, puede hacerlo de una manera que sea evidente para una máquina, pero no necesariamente para una persona normal, dice Claire Leibowicz, jefa de integridad de los medios de Partnership on AI. Y hacerlo aún depende de la buena voluntad de las plataformas utilizadas para generar el audio deepfake. «No hemos descubierto lo que significa que estas herramientas sean de código abierto para aquellos que quieran infringir la ley», añade.