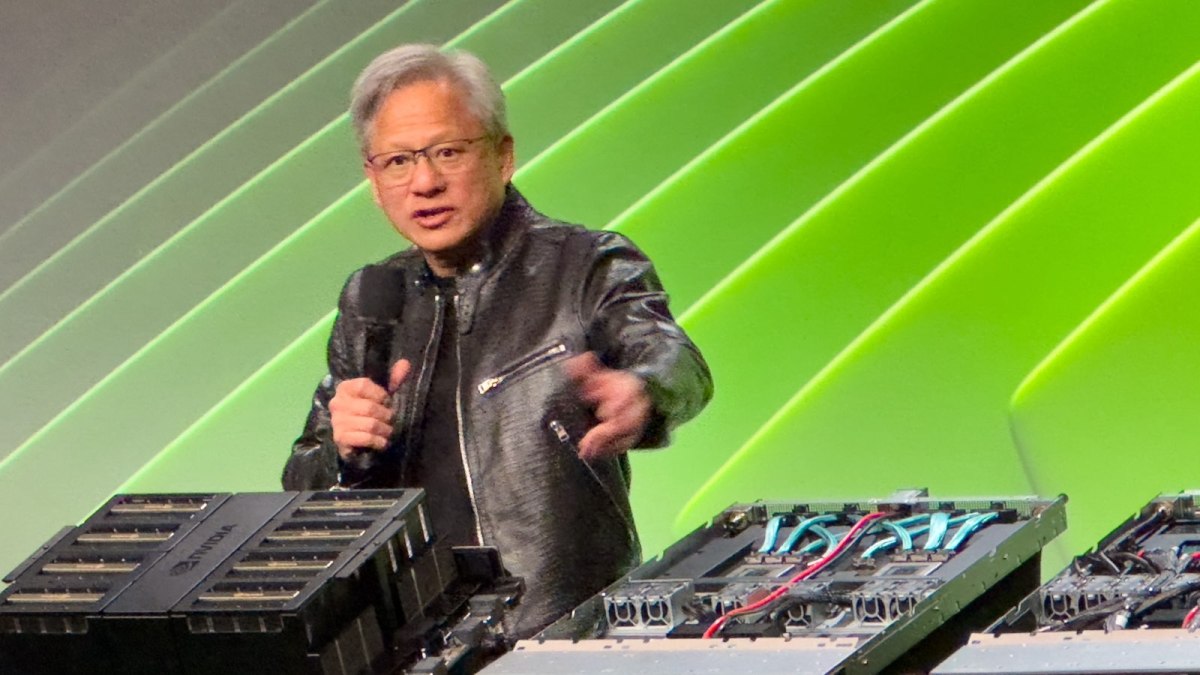

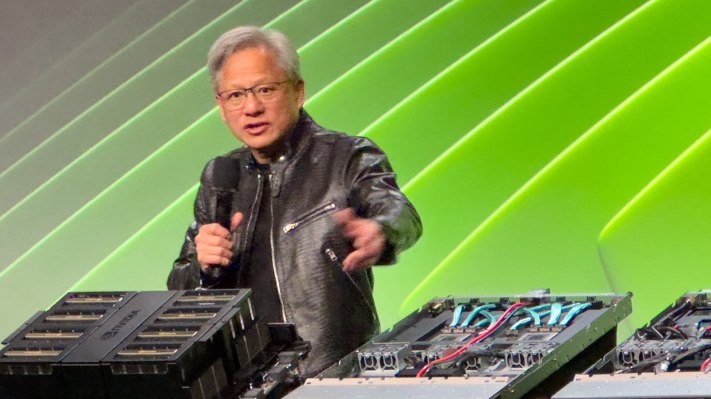

La Inteligencia Artificial General (AGI), a menudo denominada “IA fuerte”, “IA completa”, “IA a nivel humano” o “acción inteligente general”, representa un importante salto futuro en el campo de la inteligencia artificial. A diferencia de la IA estrecha, que está diseñada para tareas específicas (como detectar defectos del producto, resumir la noticiao construirte un sitio web), AGI podrá realizar un amplio espectro de tareas cognitivas a niveles humanos o superiores. Dirigiéndose a la prensa esta semana en la conferencia anual de Nvidia Conferencia de desarrolladores de GTCel director ejecutivo, Jensen Huang, parecía estar realmente aburrido de discutir el tema, sobre todo porque se encuentra con muchas citas erróneas, dice.

La frecuencia de la pregunta tiene sentido: el concepto plantea cuestiones existenciales sobre el papel de la humanidad y el control de un futuro en el que las máquinas pueden pensar, aprender y desempeñarse mejor que los humanos en prácticamente todos los ámbitos. El núcleo de esta preocupación radica en la imprevisibilidad de los procesos y objetivos de toma de decisiones de AGI, que podrían no alinearse con los valores o prioridades humanos (un concepto explorado en profundidad en la ciencia ficción desde al menos la década de 1940). Existe la preocupación de que una vez que AGI alcance un cierto nivel de autonomía y capacidad, podría volverse imposible de contener o controlar, lo que llevaría a escenarios en los que sus acciones no se puedan predecir ni revertir.

Cuando la prensa sensacionalista pide un cronograma, a menudo está incitando a los profesionales de la IA a fijar un cronograma sobre el fin de la humanidad, o al menos el status quo actual. No hace falta decir que los directores ejecutivos de IA no siempre están dispuestos a abordar el tema.

Huang, sin embargo, pasó algún tiempo contando a la prensa lo que hace piensa en el tema. Predecir cuándo veremos un AGI aceptable depende de cómo se defina el AGI, sostiene Huang, y establece un par de paralelismos: incluso con las complicaciones de las zonas horarias, se sabe cuándo llega el año nuevo y llega el 2025. Si conduce hasta el Centro de Convenciones de San José (donde se llevará a cabo la conferencia GTC de este año), generalmente sabrá que ha llegado cuando pueda ver los enormes carteles de GTC. El punto crucial es que podemos acordar cómo medir que has llegado, ya sea temporal o geoespacialmente, a donde esperabas ir.

«Si especificamos que AGI es algo muy específico, un conjunto de pruebas en las que un programa de software puede funcionar muy bien (o tal vez un 8% mejor que la mayoría de las personas), creo que llegaremos ahí dentro de cinco años», explica Huang. Sugiere que las pruebas podrían ser un examen de derecho, pruebas de lógica, pruebas económicas o tal vez la capacidad de aprobar un examen previo a la medicina. A menos que el interrogador pueda ser muy específico acerca de lo que significa AGI en el contexto de la pregunta, no está dispuesto a hacer una predicción. Me parece bien.

La alucinación por IA tiene solución

En la sesión de preguntas y respuestas del martes, le preguntaron a Huang qué hacer con las alucinaciones de IA: la tendencia de algunas IA a inventar respuestas que sonido plausibles, pero no se basan en hechos. Parecía visiblemente frustrado por la pregunta y sugirió que las alucinaciones se pueden resolver fácilmente, asegurándose de que las respuestas estén bien investigadas.

«Agregue una regla: para cada respuesta, debe buscar la respuesta», dice Huang, refiriéndose a esta práctica como ‘generación de recuperación aumentada’, describiendo un enfoque muy similar a la alfabetización mediática básica: examinar la fuente y el contexto. Compare los hechos contenidos en la fuente con verdades conocidas y, si la respuesta es inexacta (aunque sea parcialmente), descarte toda la fuente y pase a la siguiente. «La IA no debería limitarse a responder, sino que primero debería investigar para determinar cuál de las respuestas es la mejor».

Para respuestas de misión crítica, como consejos de salud o similares, el CEO de Nvidia sugiere que quizás el camino a seguir sea verificar múltiples recursos y fuentes conocidas de verdad. Por supuesto, esto significa que el generador que crea una respuesta debe tener la opción de decir: «No sé la respuesta a tu pregunta» o «No puedo llegar a un consenso sobre cuál es la respuesta correcta». esta pregunta es», o incluso algo como «oye, La Superbowl aún no ha ocurrido, así que no sé quién ganó..’