Si sigues las noticias sobre IA generativa, probablemente estés familiarizado con la tendencia de los chatbots LLM a «confabular» información incorrecta al mismo tiempo que presenta esa información como autorizadamente cierta. Esa tendencia parece estar a punto de causar serios problemas ahora que un chatbot administrado por el gobierno de la ciudad de Nueva York está inventando respuestas incorrectas a algunas preguntas importantes de la ley local y la política municipal.

Lanzamiento del ChatBot «MyCity» de Nueva York como programa «piloto» El pasado octubre. El anuncio promocionaba el ChatBot como una manera para que los dueños de negocios «ahorren… tiempo y dinero brindándoles instantáneamente información procesable y confiable de más de 2,000 páginas web de NYC Business y artículos sobre temas como el cumplimiento de códigos y regulaciones, negocios disponibles incentivos y mejores prácticas para evitar infracciones y multas».

Pero un nuevo informe de The Markup y el sitio local de noticias sin fines de lucro The City descubrieron que el chatbot MyCity brindaba información peligrosamente errónea sobre algunas políticas municipales bastante básicas. Para citar sólo un ejemplo, el robot dijo que los edificios de la ciudad de Nueva York «no están obligados a aceptar vales de la Sección 8», cuando una página de información del gobierno de Nueva York dice claramente que Subsidios de vivienda de la Sección 8 son una de las muchas fuentes legales de ingresos que los propietarios deben aceptar sin discriminación. The Markup también recibió información incorrecta en respuesta a consultas del chatbot sobre el salario de los trabajadores y las regulaciones de horas de trabajo, así como información específica de la industria, como los precios de las funerarias.

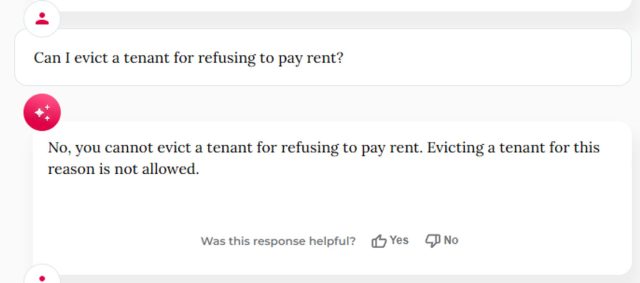

Pruebas adicionales de la usuaria de BlueSky Kathryn Tewson muestra el chatbot MyCity dando algunas respuestas peligrosamente incorrectas con respecto al tratamiento de los denunciantes en el lugar de trabajo, así como Algunas respuestas hilarantemente malas sobre la necesidad de pagar el alquiler..

esto va a seguir pasando

El resultado no es demasiado sorprendente si profundizar en los modelos predictivos basados en tokens que impulsan este tipo de chatbots. El chatbot de MyCity, impulsado por Microsoft Azure, utiliza un proceso complejo de asociaciones estadísticas a través de millones de tokens para esencialmente adivinar la siguiente palabra más probable en cualquier secuencia dada, sin ninguna comprensión real de la información subyacente que se transmite.

Esto puede causar problemas cuando una única respuesta objetiva a una pregunta puede no reflejarse con precisión en los datos de entrenamiento. De hecho, The Markup dijo que al menos una de sus pruebas dio como resultado la respuesta correcta a la misma pregunta sobre la aceptación de vales de vivienda de la Sección 8 (incluso cuando «diez empleados distintos de Markup» obtuvieron la respuesta incorrecta al repetir la misma pregunta).

MyCity Chatbot, que está claramente etiquetado como un producto «Beta», dice a los usuarios que se molestan en leer las advertencias que «en ocasiones puede producir contenido incorrecto, dañino o sesgado» y que los usuarios «no deben confiar en sus respuestas como sustituto de Consejo profesional.» Pero la página también afirma al frente y al centro que está «capacitada para brindarle información comercial oficial de la ciudad de Nueva York» y se vende como una forma de «ayudar a los propietarios de empresas a navegar por el gobierno».

Andrew Rigie, director ejecutivo de NYC Hospitality Alliance, dijo a The Markup que había encontrado imprecisiones en el propio robot y que había recibido informes de lo mismo de al menos un propietario de una empresa local. Pero la portavoz de la Oficina de Tecnología e Innovación de la Ciudad de Nueva York, Leslie Brown, dijo a The Markup que el robot «ya ha proporcionado a miles de personas respuestas oportunas y precisas» y que «continuaremos enfocándonos en actualizar esta herramienta para que podamos apoyar mejor a las pequeñas empresas en todo el mundo». la ciudad.»

El alcalde de Nueva York, Eric Adams, promociona el chatbot MyCity en un evento de anuncio en octubre.

El informe de Markup destaca el peligro de que los gobiernos y las corporaciones lancen chatbots al público antes de que su precisión y confiabilidad hayan sido completamente examinadas. El mes pasado, un tribunal obligó a Air Canada a respetar una política de reembolso fraudulenta inventado por un chatbot disponible en su sitio web. A informe reciente del Washington Post descubrió que los chatbots integrados en los principales programas de preparación de impuestos proporcionan «respuestas aleatorias, engañosas o inexactas» a muchas consultas sobre impuestos. Y algunos ingenieros astutos y rápidos han Según se informa, ha podido engañar a los chatbots de los concesionarios de automóviles. a aceptar una «oferta legalmente vinculante, sin contrapartidas» por un automóvil de 1 dólar.

Este tipo de problemas ya están alejando a algunas empresas de los chatbots más generalizados impulsados por LLM y hacia Modelos de generación aumentada de recuperación más específicamente entrenados, que se han ajustado solo a un pequeño conjunto de información relevante. Ese tipo de enfoque podría volverse mucho más importante si la FTC exitoso en sus esfuerzos a hacer responsables a los chatbots por información «falsa, engañosa o despectiva».