El rival más cercano de Nvidia una vez más arrasa con los gigantes de la nube en rendimiento de IA; Cerebras Inference es 75 veces más rápido que AWS, 32 veces más rápido que Google en Llama 3.1 405B

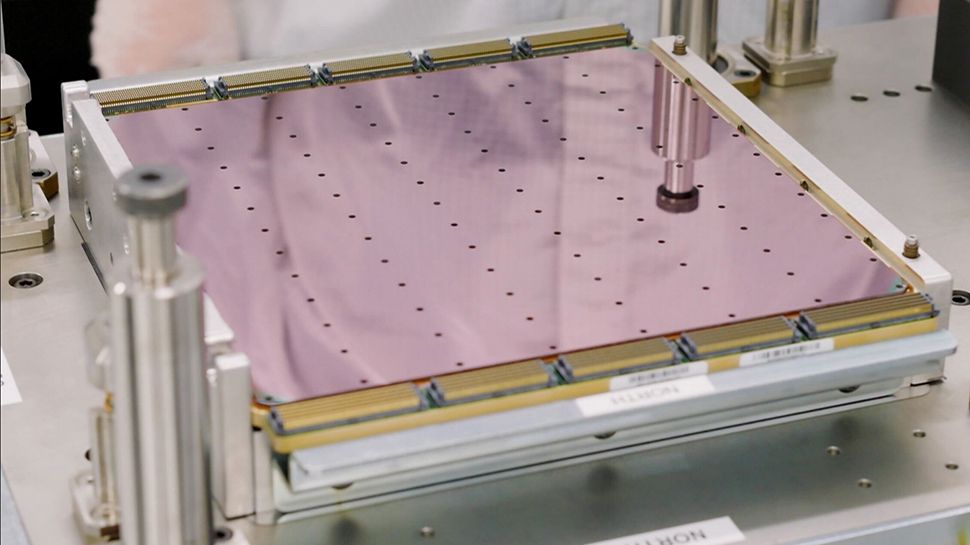

[ad_1] Cerebras alcanza 969 tokens/segundo en Llama 3.1 405B, 75 veces más rápido que AWS Afirma una latencia de 240 ms, la más baja de la industria, dos veces más rápida que Google Vertex Cerebras Inference se ejecuta en el...