[ad_1]

Los «deepfakes» generados por inteligencia artificial que se hacen pasar por políticos y celebridades son mucho más frecuentes que los esfuerzos por utilizar la IA para ayudar en los ciberataques, según la primera investigación realizada por la división DeepMind de Google sobre los usos maliciosos más comunes de esta tecnología de vanguardia.

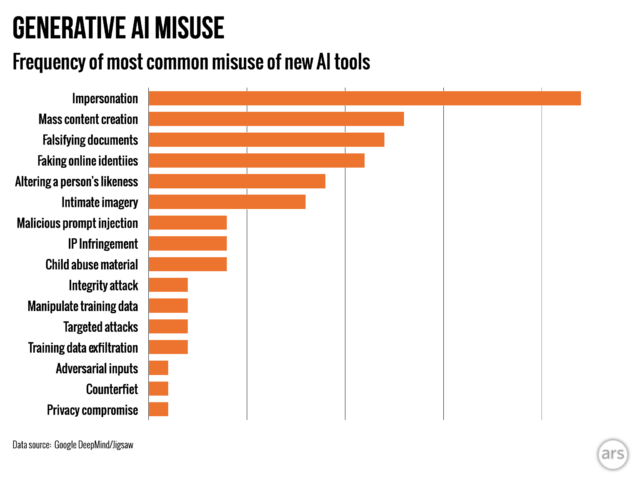

El estudio dijo que la creación de imágenes, videos y audio realistas pero falsos de personas era casi dos veces más común que el siguiente uso indebido de herramientas de inteligencia artificial generativa: la falsificación de información utilizando herramientas basadas en texto, como chatbots, para generar información errónea para publicar en línea. .

El objetivo más común de los actores que hacen mal uso de la IA generativa era moldear o influir en la opinión pública, según encontró el análisis, realizado con la unidad de investigación y desarrollo del grupo de búsqueda, Jigsaw. Eso representó el 27 por ciento de los usos, lo que alimentó los temores sobre cómo los deepfakes podrían influir en las elecciones a nivel mundial este año.

En los últimos meses han aparecido en TikTok, X e Instagram deepfakes del primer ministro del Reino Unido, Rishi Sunak, así como de otros líderes mundiales. Los votantes del Reino Unido acudirán a las urnas la próxima semana en unas elecciones generales.

Existe una preocupación generalizada de que, a pesar de los esfuerzos de las plataformas de redes sociales por etiquetar o eliminar dicho contenido, el público no los reconozca como falso y la difusión del contenido podría influir en los votantes.

Ardi Janjeva, investigador asociado del Instituto Alan Turing, calificó de «especialmente pertinente» el hallazgo del artículo de que la contaminación de información de acceso público con contenido generado por IA podría «distorsionar nuestra comprensión colectiva de la realidad sociopolítica».

Janjeva añadió: “Incluso si no estamos seguros del impacto que tienen los deepfakes en el comportamiento electoral, esta distorsión puede ser más difícil de detectar en el plazo inmediato y plantea riesgos a largo plazo para nuestras democracias”.

El estudio es el primero de su tipo realizado por DeepMind, la unidad de inteligencia artificial de Google dirigida por Sir Demis Hassabis, y es un intento de cuantificar los riesgos del uso de herramientas de inteligencia artificial generativa, que las mayores empresas tecnológicas del mundo han lanzado al público en busca de información. de enormes ganancias.

A medida que se utilizan más ampliamente productos generativos como ChatGPT de OpenAI y Gemini de Google, las empresas de IA están comenzando a monitorear la avalancha de información errónea y otros contenidos potencialmente dañinos o poco éticos creados por sus herramientas.

En mayo, OpenAI publicó una investigación que revelaba que operaciones vinculadas a Rusia, China, Irán e Israel habían estado utilizando sus herramientas para crear y difundir desinformación.

«Hubo mucha preocupación comprensible en torno a ataques cibernéticos bastante sofisticados facilitados por estas herramientas», dijo Nahema Marchal, autora principal del estudio e investigadora de Google DeepMind. “Mientras que lo que vimos fueron usos indebidos bastante comunes de GenAI [such as deepfakes that] Podría pasar un poco más desapercibido”.

Los investigadores de Google DeepMind y Jigsaw analizaron alrededor de 200 incidentes de uso indebido observados entre enero de 2023 y marzo de 2024, tomados de las plataformas de redes sociales X y Reddit, así como de blogs en línea e informes de uso indebido en los medios.

Ars Técnica

La segunda motivación más común detrás del uso indebido era ganar dinero, ya sea ofreciendo servicios para crear deepfakes, incluida la generación de representaciones desnudas de personas reales, o utilizando IA generativa para crear franjas de contenido, como artículos de noticias falsas.

La investigación encontró que la mayoría de los incidentes utilizan herramientas de fácil acceso, que “requieren una experiencia técnica mínima”, lo que significa que más actores malintencionados pueden hacer un mal uso de la IA generativa.

La investigación de Google DeepMind influirá en cómo mejora sus evaluaciones para probar la seguridad de los modelos, y espera que también afecte la forma en que sus competidores y otras partes interesadas ven cómo «se manifiestan los daños».

© 2024 El Financial Times Ltd.. Reservados todos los derechos. No debe ser redistribuido, copiado ni modificado de ninguna manera.

[ad_2]

Enlace fuente