[ad_1]

He recurrido a instalado localmente AI para la investigación porque no quiero que terceros que usen mi información para construir un perfil o entrenar su modelos de idiomas locales (LLMS).

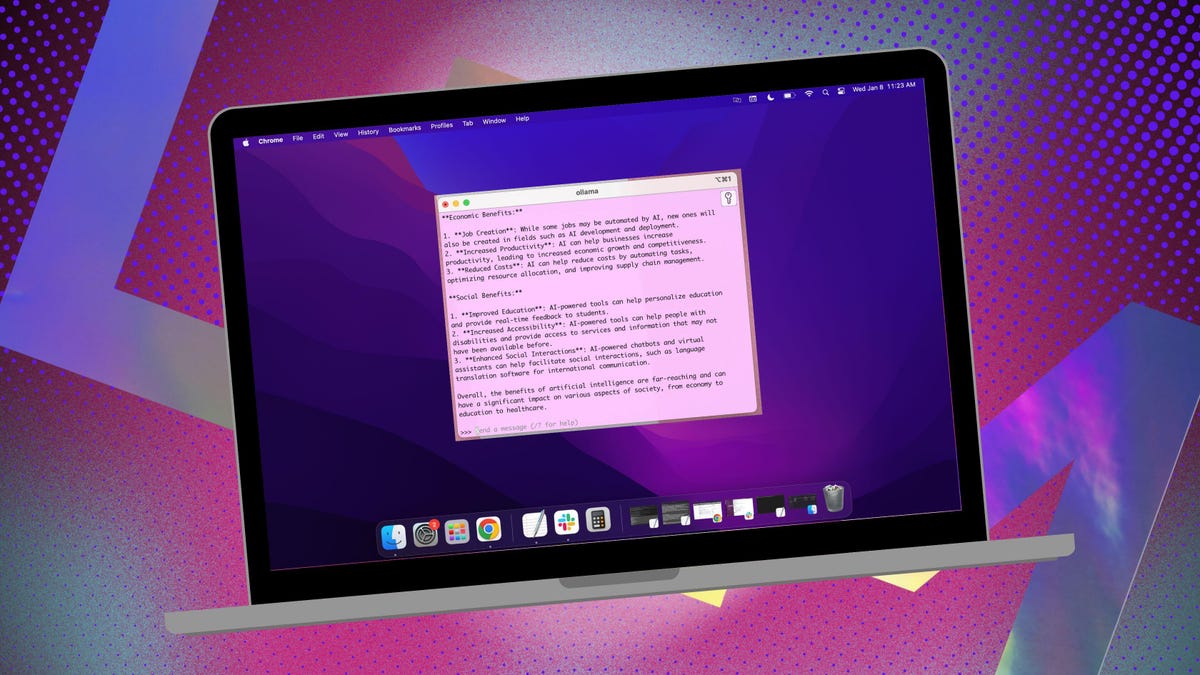

Mi IA local de elección es la fuente abierta Ollama. Recientemente escribí un artículo sobre cómo facilitar el uso de este LLM local con la ayuda de un extensión del navegadorque uso en Linux. Pero en MacOS, recurro a una aplicación fácil de usar y gratuita llamada Msty.

MSTY le permite usar modelos de IA instalados localmente y en línea. Sin embargo, predetogo la opción instalada localmente. Y, a diferencia de las otras opciones para Ollama, no hay un contenedor para implementar, no hay terminal para usar, y no es necesario abrir otra pestaña del navegador.

Msty presenta cosas como chats divididos (para que pueda ejecutar más de una consulta a la vez), regenerar la respuesta del modelo, los chats clonados, agregar múltiples modelos, convocar datos en tiempo real (que solo funciona con ciertos modelos), crear pilas de conocimiento (donde Puede agregar archivos, carpetas, bóvedas de obsidiana, notas y más que se utilizarán para capacitar a su modelo local), una biblioteca rápida y más.

Msty es una de las mejores herramientas para interactuar con Ollama. Aquí le mostramos cómo usarlo.

Instalación de MSTY

Lo que necesitarás: Lo único que necesitará para esto es un dispositivo MacOS, y Ollama instaló y en ejecución. Si no ha instalado Ollama, haz eso primero (Aquí está como). También necesitará retirar uno de los modelos locales (que se demuestra en el artículo anterior).

Dirígete al Sitio web de Mstyhaga clic en Descargar el menú desplegable Msty, seleccionar Mac y luego seleccione Apple Silicon o Intel.

Mostrar más

Cuando se complete la instalación, haga doble clic en el archivo y, cuando se le solicite, arrastre el icono MSTY a la carpeta de aplicaciones.

Mostrar más

Usando Msty

1. Abra Msty

A continuación, abra LaunchPad y ubique el lanzador para MSTY. Haga clic en el lanzador para abrir la aplicación.

2. Conecte su modelo Ollama local

Cuando ejecute MSTY por primera vez, haga clic en Configurar la IA local y descargará los componentes necesarios. Una vez que se complete la descarga, se encargará de la configuración y descargará un modelo local que no sea Ollama.

Para conectar Msty a Ollama, haga clic en los modelos de IA locales en la barra lateral y luego haga clic en el botón Descargar asociado con Llama 3.2. Una vez descargado, puede seleccionarlo desde el menú desplegable de modelos. También puede agregar otros modelos, para los cuales necesitará recuperar una clave API de su cuenta para ese modelo en particular. Msty ahora debería estar conectado al local Ollama LLM.

Prefiero usar el modelo local Ollama.

Captura de pantalla de Jack Wallen/Zdnet

En este punto, puede escribir su primera consulta y esperar la respuesta.

3. Instrucciones del modelo

Una de las características geniales de MSTY es que le permite cambiar las instrucciones del modelo.

Por ejemplo, es posible que desee usar el LLM local como médico asistido por AI, para escribir, contabilidad, como antropólogo alienígena o como asesor artístico.

Para cambiar las instrucciones del modelo, haga clic en Editar instrucciones del modelo en el centro de la aplicación y luego haga clic en el botón de chat pequeño a la izquierda del icono de la escoba.

También: La mejor IA para codificar en 2025 (y qué no usar)

En el menú emergente, puede seleccionar las instrucciones que desea aplicar. Haga clic en «Aplicar a este chat» antes de ejecutar su primera consulta.

Puede elegir entre varias instrucciones de modelo para perfeccionar sus consultas.

Captura de pantalla de Jack Wallen/Zdnet

Hay muchas otras cosas que Msty puede hacer, pero esta guía lo pondrá en funcionamiento rápidamente. Sugeriría comenzar con los conceptos básicos y, a medida que te acostumbras a la aplicación, aventurarme en procesos más complicados.

[ad_2]

Enlace fuente