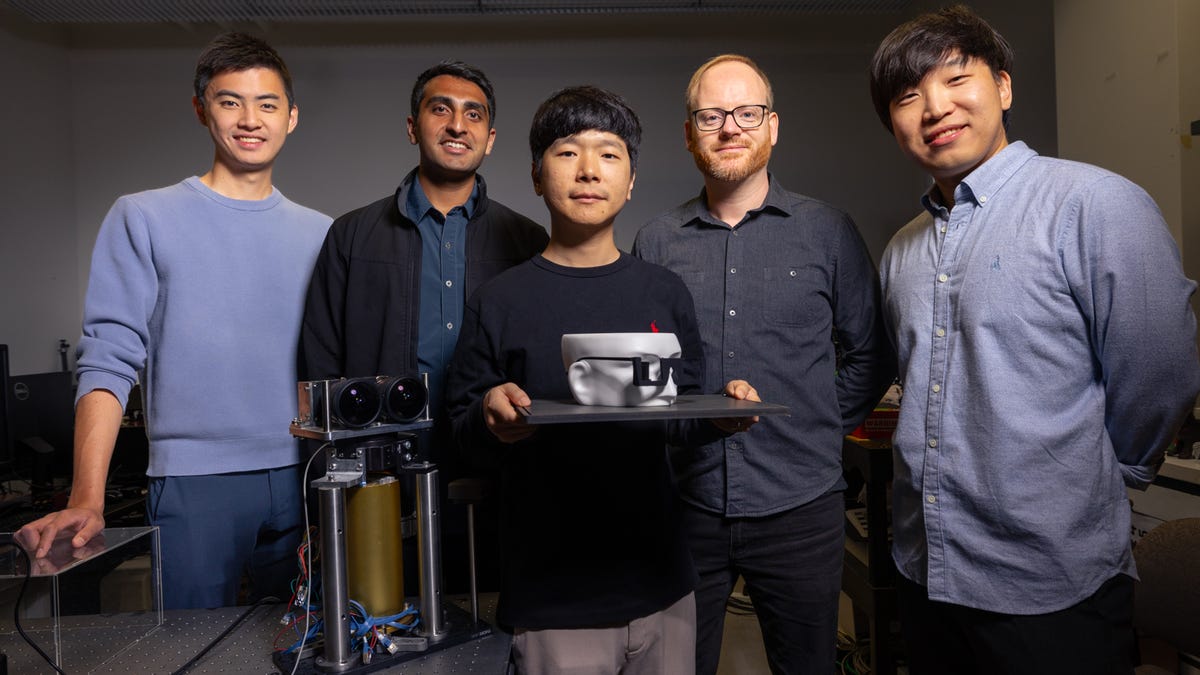

Equipo de investigación en Stanford de izquierda a derecha: Brian Chao, Manu Gopakumar, Gun-Yeal Lee, Gordon Wetzstein, Suyeon Choi (Foto de Andrew Brodhead).

Imagen: Ingeniería de Stanford

Una de las mayores críticas a la AR y la VR, y especialmente a la visión de Apple de lo que llama «computación espacial«, es la mayor parte de las gafas. No hay duda de que hemos llegado al punto en el que algunos dispositivos y experiencias XR son increíbles, pero hay un muro bastante alto de molestias que escalar para usarlos.

Los dispositivos son pesados, feos e incómodos, y aunque el niño de cuatro años Quest 2 está disponible por $200los precios suben y suben, con el $3500 Apple Vision Pro causando que las billeteras implosionen.

También: Por qué las gafas inteligentes Ray-Ban de Meta son mi compra tecnológica favorita este año

Aunque hace tiempo que vemos la promesa de la realidad virtual y todos esperamos que la tecnología mejore, hemos tenido que confiar principalmente en el ritmo histórico del avance tecnológico para brindarnos la seguridad de un futuro más práctico. Pero ahora estamos empezando a ver que se está produciendo ciencia real que muestra cómo todo esto podría ser posible.

Un equipo de investigadores de la Universidad de Stanford, dirigido por el profesor asociado de ingeniería Gorden Wetzstein, ha construido un prototipo de gafas ligeras que puede mostrar imágenes digitales frente a tus ojos, combinándolas perfectamente con el mundo real. Su equipo se especializa en tecnologías de visualización y imágenes computacionales. Han estado trabajando para integrar información digital en nuestra percepción visual del mundo real.

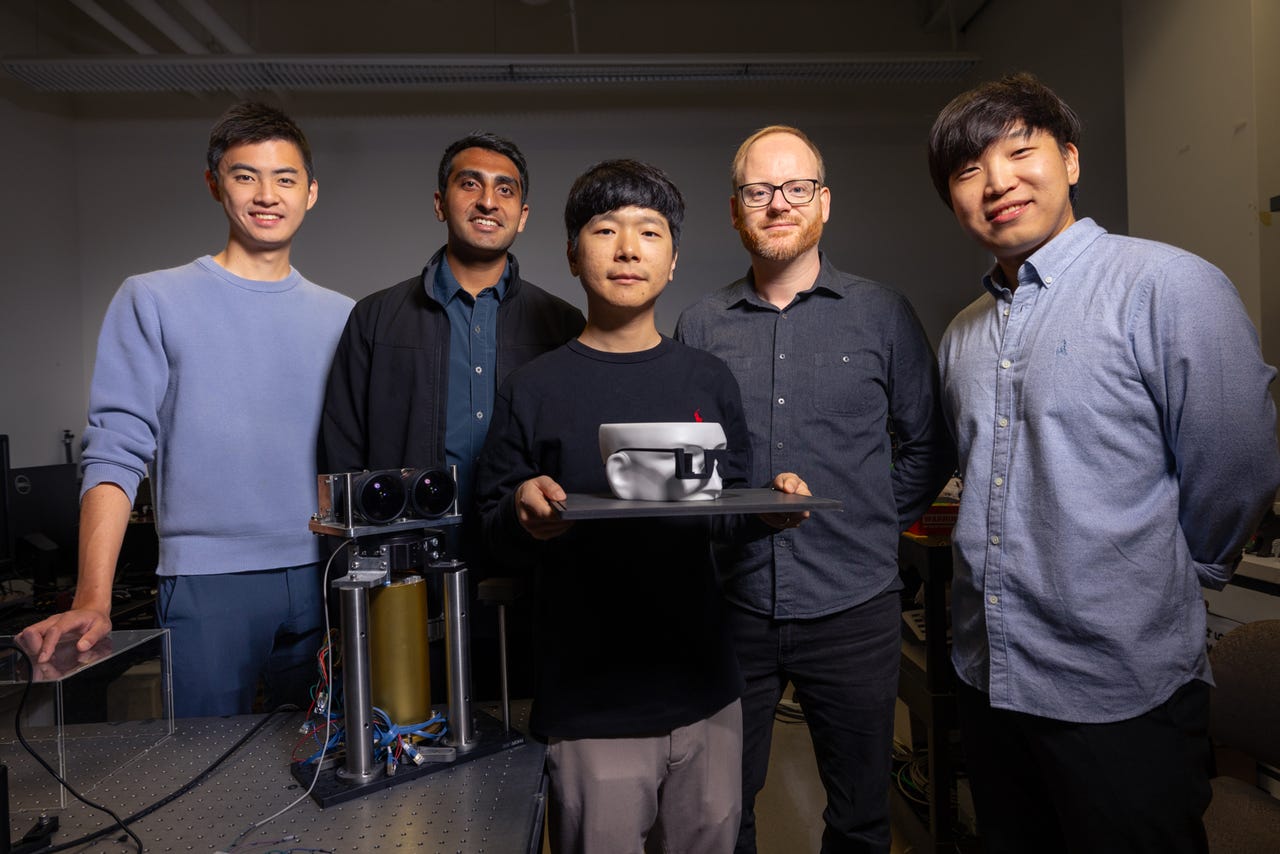

«Nuestros auriculares aparecen ante el mundo exterior como un par de gafas cotidianas, pero lo que el usuario ve a través de las lentes es un mundo enriquecido superpuesto con imágenes computarizadas en 3D vibrantes y a todo color», dice Wetzstein. «Las pantallas holográficas se han considerado durante mucho tiempo la técnica 3D definitiva, pero nunca han logrado ese gran avance comercial… Tal vez ahora tengan la aplicación espectacular que han estado esperando todos estos años».

También: Los mejores cascos de realidad virtual de 2024: probados y revisados por expertos

Entonces, ¿qué está haciendo el equipo de Wetzstein que sea diferente del trabajo de Apple y Meta?

Gafas holográficas prototipo

Imagen: Ingeniería de Stanford

El equipo de Stanford se centra en tecnologías fundamentales y avances científicos en realidad aumentada holográfica e imágenes computacionales. Están investigando para crear nuevas formas de generar experiencias visuales más naturales e inmersivas utilizando técnicas sofisticadas como guías de ondas de metasuperficie y holografía impulsada por IA.

¿Guías de ondas de metasuperficie?

Deconstruyamos ambas palabras. Una metasuperficie es un material diseñado que consta de estructuras diminutas dispuestas con precisión en una superficie. Estas estructuras son más pequeñas que las longitudes de onda de la luz con la que interactúan.

La idea es que estas pequeñas nanoestructuras, llamadas guías de ondas, manipulen la luz de manera estratégica, alterando la fase, la amplitud y la polarización a medida que atraviesa el material. Esto permite a los ingenieros ejercer un control muy detallado sobre la luz.

Lo que hemos estado viendo tanto con Quest 3 como con Vision Pro es el uso de pantallas de computadora tradicionales, pero reducidas para caber frente a nuestros ojos. La tecnología de visualización es impresionante, pero sigue siendo una evolución del rendimiento de la pantalla.

El enfoque de Stanford descarta eso para que la computadora no controle directamente una pantalla. En cambio, controla los caminos de la luz utilizando guías de ondas. Radicalmente simplificado, utiliza estos tres enfoques:

Modulación de luz espacial: La CPU o GPU de una computadora controla los moduladores de luz espacial (SLM) que ajustan la luz que ingresa a las guías de ondas. Se trata de pequeños dispositivos que se utilizan para controlar la intensidad, la fase o la dirección de la luz píxel por píxel. Al manipular las propiedades de la luz, dirigen y manipulan la luz misma a nivel nano.

Patrones de luz complejos: Un dispositivo de realidad virtual calcula y genera patrones de luz complejos, lo que permite que los auriculares dicten las formas específicas en que la luz interactúa con la metasuperficie. Esto, a su vez, modifica la imagen final vista por un usuario.

Ajustes en tiempo real: Luego, las computadoras realizan ajustes en tiempo real a las secuencias de nanoluz, basándose en la interacción del usuario y el cambio ambiental. La idea es asegurarse de que el contenido mostrado sea estable y preciso para diversas condiciones y actividades de iluminación.

Puede ver por qué la IA es fundamental en esta aplicación

Hacer toda esta magia de la luz industrial no es fácil. La IA necesita hacer gran parte del trabajo pesado. Esto es algo de lo que la IA tiene que hacer para que esto sea posible:

Mejorar la formación de imágenes: Los algoritmos de IA utilizan una combinación de modelado físicamente preciso y atributos de componentes aprendidos para predecir y corregir cómo la luz atraviesa el entorno holográfico.

Optimización de la manipulación del frente de onda: Las IA tienen que ajustar la fase y la amplitud de la luz en varias etapas para generar el resultado visual deseado. Lo hacen mediante una manipulación precisa de los frentes de onda en el entorno XR.

Manejo de cálculos complejos: Esto, por supuesto, requiere muchas matemáticas. Es necesario modelar el comportamiento de la luz dentro de la guía de ondas de la metasuperficie, ocupándose de la difracción, interferencia y dispersión de la luz.

Si bien algunos de estos desafíos podrían ser posibles utilizando la informática tradicional de arriba hacia abajo, la mayor parte del proceso requiere capacidades que van más allá de las capacidades de los enfoques tradicionales. La IA tiene que avanzar de las siguientes maneras:

Reconocimiento y adaptación de patrones complejos: Un sello distintivo de la capacidad de la IA, especialmente en términos de aprendizaje automático, es la capacidad de reconocer patrones complejos y adaptarse a nuevos datos sin requerir explícitamente una nueva programación. Con la holografía AR, esta capacidad permite a la IA lidiar con miles de variables involucradas en la propagación de la luz (cambios de fase, patrones de interferencia, efectos de difracción y más) y luego corregir los cambios dinámicamente.

Procesamiento y optimización en tiempo real: Esa corrección dinámica debe realizarse en tiempo real, y cuando hablamos de luz que entra al ojo, lo que se necesita es una respuesta verdaderamente instantánea. Incluso el más mínimo retraso puede causar problemas al usuario, que van desde una ligera molestia hasta náuseas violentas. Pero con la capacidad de la IA para procesar enormes cantidades de datos a medida que fluyen y luego realizar ajustes instantáneos, es posible el procesamiento de luz compatible con los humanos para la visión AR.

Aprendizaje automático a partir de comentarios: El aprendizaje automático permite que los sistemas XR mejoren dinámicamente con el tiempo, procesando la retroalimentación de la cámara y refinando continuamente las imágenes holográficas proyectadas, reduciendo errores y mejorando la calidad de la imagen.

Manejo de datos no lineales y de alta dimensión: Las matemáticas involucradas en cómo la luz interactúa con superficies complejas, especialmente las metasuperficies utilizadas en holografía, a menudo requieren cálculos basados en datos tremendamente no lineales y que contienen grandes conjuntos de puntos de datos. Las IA están diseñadas para gestionar estos datos aprovechando la capacidad del aprendizaje automático para manejar conjuntos de datos complejos y realizar procesamiento en tiempo real.

Integración de diversos tipos de datos: Los datos disponibles para producir las imágenes requeridas en la RA holográfica no se limitan a conjuntos gigantes de coordenadas X/Y. Las IA pueden procesar datos ópticos, datos espaciales e información ambiental, y utilizarlos todos para crear imágenes compuestas.

Que significa todo esto?

Sin duda, el factor más importante que frena la popularidad de los dispositivos de computación espacial y XR es la mayor parte de los auriculares. Si una funcionalidad como la que se encuentra en Quest 3 o el Visión Pro Si estuvieran disponibles en un par de gafas tradicionales, el potencial sería enorme.

También: Meta Quest 2 vs Quest 3: ¿Qué casco de realidad virtual deberías comprar?

Existe un límite en lo pequeños que pueden llegar a ser los vasos al incorporar pantallas tradicionales. Pero al cambiar las propiedades ópticas del propio vidrio, los científicos estarían aprovechando el dispositivo de realidad aumentada más aceptado de la historia: nuestras gafas.

Desafortunadamente, lo que el equipo de Stanford tiene ahora es un prototipo. Es necesario desarrollar mucho más la tecnología para pasar de la investigación a la ciencia fundamental, al laboratorio de ingeniería y luego a la producción. Si bien el equipo de Stanford no predijo cuánto tiempo llevaría esto, sería una apuesta justa suponer que esta tecnología tardará al menos entre cinco y diez años.

Pero no dejes que eso te desanime. Han pasado aproximadamente 17 años desde que se lanzó el primer iPhone e incluso en los primeros tres o cuatro años del dispositivo, vimos una mejora enorme. Espero que veamos mejoras similares en los próximos años para la generación actual de computación espacial y dispositivos XR.

Por supuesto, el futuro está ahí fuera. ¿Cómo será esto dentro de 17 años? Quizás el equipo de Stanford nos haya dado un primer vistazo.

Puedes seguir las actualizaciones diarias de mi proyecto en las redes sociales. Asegúrate de suscribirte a mi boletín de actualización semanaly sígueme en Twitter/X en @DavidGewirtzen Facebook en Facebook.com/DavidGewirtzen Instagram en Instagram.com/DavidGewirtzy en YouTube en YouTube.com/DavidGewirtzTV.