[ad_1]

- El fabricante de chip de IA más rápido del mundo hace un chapoteo con un breve de bienvenida a bordo

- Cerebras dice que la solución ocupará 57 veces más rápido que en las GPU, pero no menciona qué GPU

- Deepseek R1 se ejecutará en Cerebras Cloud y los datos permanecerán en los EE. UU.

Cerebras ha anunciado que apoyará a Deepseek en un movimiento no tan sorprendente, más específicamente el modelo de razonamiento R1 70B. El movimiento viene después Gle y Microsoft confirmó que también llevarían al nuevo niño del bloque de IA a sus respectivas nubes. AWS y Google Cloud aún no lo ha hecho, pero cualquiera puede ejecutar el modelo de código abierto en cualquier lugar, incluso localmente.

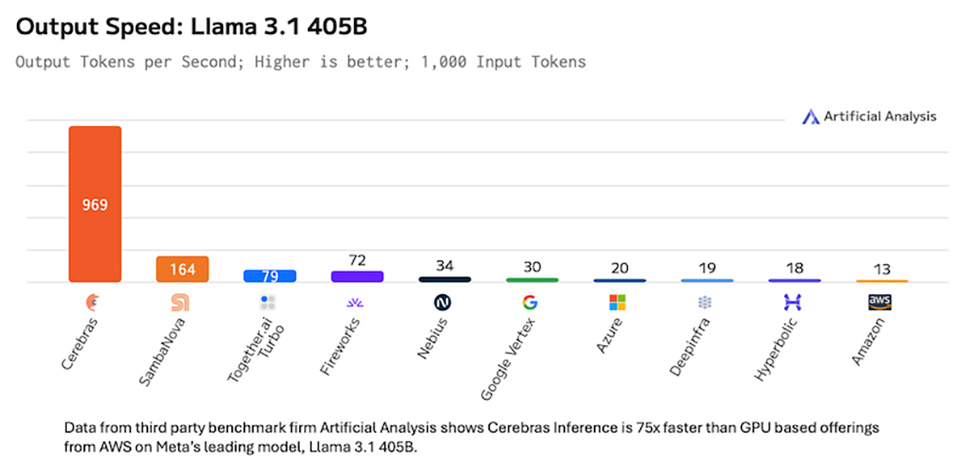

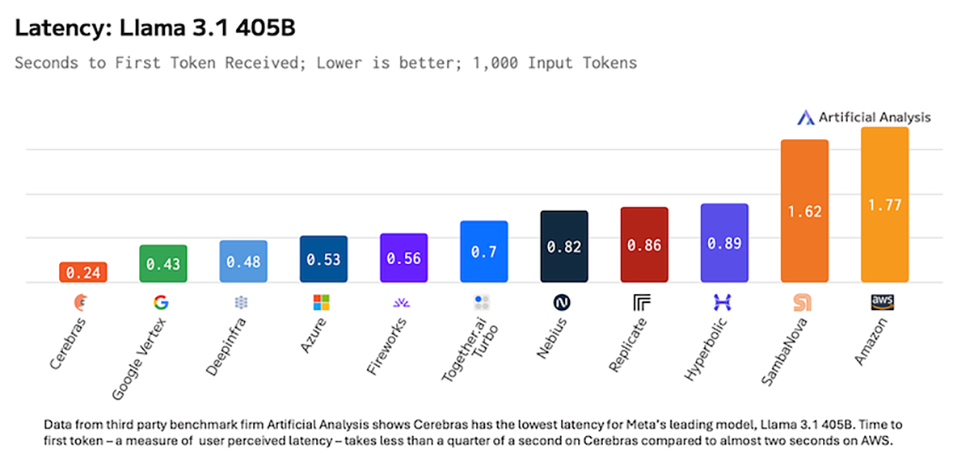

El especialista en chip de inferencia de IA ejecutará Deepseek R1 70B a 1.600 tokens/segundo, lo que afirma que es 57 veces más rápido que cualquier proveedor R1 que use GPU; Uno puede deducir que 28 tokens/segundo es lo que la solución GPU en la nube (en ese caso Deepinfra) aparentemente alcanza. Por casualidad, el último chip de cerebras es 57 veces más grande que el H100. Me he comunicado con las cerebras para obtener más información sobre esa afirmación.

La investigación de las cerebras también demostró que Deepseek es más precisa que Opadai modelos en varias pruebas. El modelo se ejecutará en hardware de cerebras en centros de datos con sede en EE. UU. Para calmar las preocupaciones de privacidad que muchos expertos han expresado. Deepseek – la aplicación – Enviará sus datos (y metadatos) a China donde probablemente se almacenará. Nada sorprendente aquí como casi todas las aplicaciones – especialmente los libres – Capture los datos del usuario por razones legítimas.

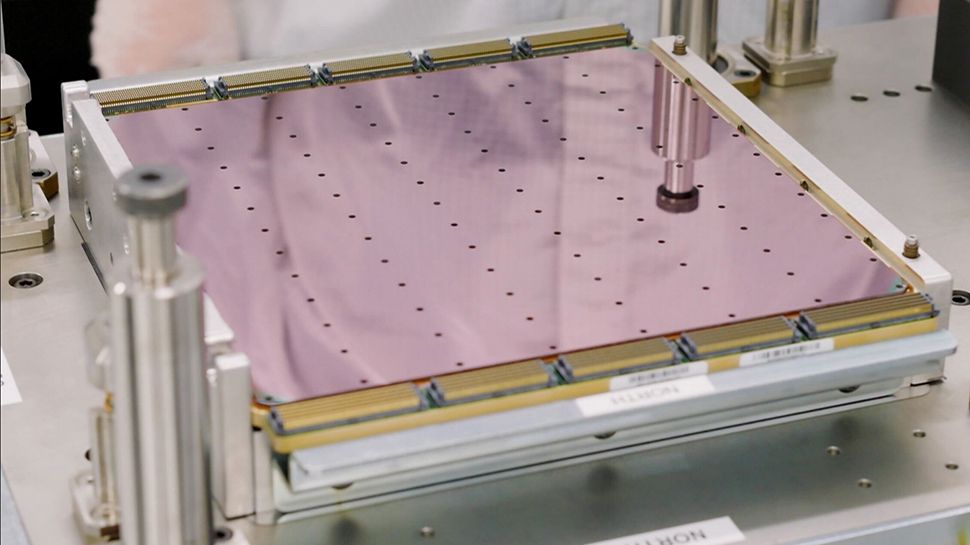

La solución de la escala de obleas de cerebras se posiciona de manera única para beneficiarse del inminente boom de inferencia de nubes de IA. WSE-3, que es el chip AI más rápido (o acelerador de HPC) del mundo, tiene casi un millón de núcleos y un asombroso cuatro trillones de transistores. Sin embargo, lo más importante es que tiene 44 GB de SRAM, que es la memoria más rápida disponible, incluso más rápido que HBM que se encuentra en NvidiaLas GPU. Dado que WSE-3 es solo un gran dado, la banda de memoria disponible es enorme, varios órdenes de magnitud más grandes que lo que puede reunir el NVIDIA H100 (y para el caso el H200).

Una guerra de precios se está gestando antes del lanzamiento de WSE-4

Todavía no se han revelado precios, pero las cerebras, que generalmente son tímidas sobre ese detalle particular, divulgó el año pasado que Llama 3.1 405b en inferencia de cerebras costaría $ 6/millones de tokens de entrada y tokens de salida de $ 12/millones. Espere que Deepseek esté disponible por mucho menos.

WSE-4 es la próxima iteración de WSE-3 y ofrecerá un impulso significativo en el rendimiento de Deepseek y modelos de razonamiento similares cuando se espera que se lance en 2026 o 2027 (dependiendo de las condiciones del mercado).

Es probable que la llegada de Deepseek también sacudiera el proverbial árbol de dinero de IA, que traiga más competencia a jugadores establecidos como OpenAi o Anthrope, lo que empuja los precios.

Un vistazo a Docsbot.ai LLM API Calculadora Shows Openai es casi siempre el más caro en todas las configuraciones, a veces por varios órdenes de magnitud.

También te puede gustar

[ad_2]

Enlace fuente